Madrid, 9 Nov. (Portaltic/EP) – El superordenador Eos de Nvidia ha reducido el tiempo de entrenamiento de modelos de inteligencia artificial (IA) en menos de seis meses, hasta lograr entrenar GPT-3 con 175.000 millones de parámetros en menos de cuatro minutos.

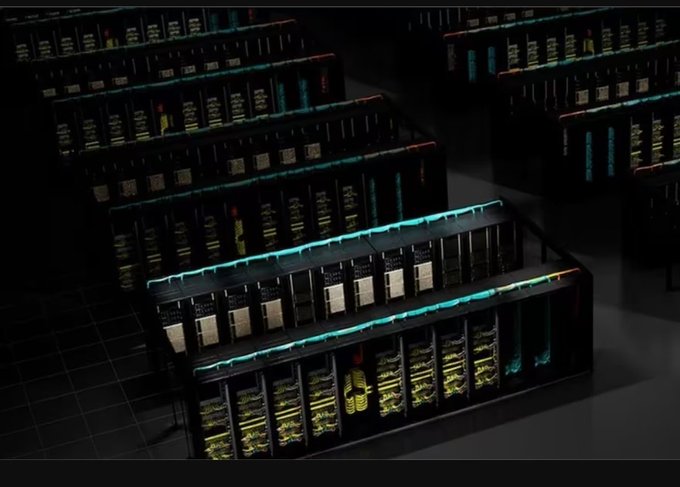

Nvidia presentó Eos en marzo del año pasado. Entonces, se esperaba que fuese el sistema de computación de IA más rápido del mundo con sus 4.608 GPU DGX H100 y 576 sistemas DGX H100, con los que ofrecía un rendimiento de 18,4 exaflops.

Este superornador se ha actualizado; cuenta con 10.752 GPU H100 Tensor Core y la red Quantum-2 InfiniBand de Nvidia. Esta configuración le ha permitido superar un test de entrenamiento de IA basado en un modelo GPT-3 con 175.000 millones de parámetros entrenado en mil millones de tokens en 3,9 minutos.

La prueba se introdujo en junio, cuando el superordenador, entonces con 3.584 PGU H100, completo el entrenamiento del modelo GPT-3 en 10,9 minutos. Esto es, ha reducido por tres el tiempo en menos de seis meses, como recoge Nvidia en una nota de prensa.

En la prueba reciente, además de escalar las GPU, también se han utilizado «una plataforma completa de innovaciones en aceleradores, sistemas y software», también en Azure, la nube de Microsoft.

La compañía tecnológica ha apuntado que «la aceleración del tiempo de formación reduce los costes, ahorra energía y acelera el tiempo de comercialización».